文|王磊

编辑|秦章勇

首个真正意义上具备复杂交互能力的机器人,出现了。

它的创造者就是此前从华为离职的天才少年——曾经带着各种硬核DIY作品火遍全网的男人——稚晖君。

3月11日,智元机器人联合创始人稚晖君(彭志辉)发布视频称,这鸽了2年之后,第一次正儿八经地更新视频。

在视频中,他正式介绍了智元最新研发的双足智能交互人形机器人——灵犀 X2。

除了常规的行走、跑、跳,X2还点满了运动天赋,不仅能举重蹲起,还能踩滑板车,甚至还能自己骑自行车。

有“人味儿”的机器人

作为 X1 的“全能小老弟”,灵犀X2同样是由智元半年前成立的机器人实验室 X-Lab 打造出来的,而且从X1到X2的研发,仅用了三个月。

和之前发布的原型机器人X1一样,X2全身一共28个自由度,体重为33.8千克,身高1.3米左右,当然,X2的本体设计还新加入了大量的技术创新思考。

比如,重新设计的机电关节模组,在全身28个的自由度中,没有使用到任何一个并联结构,这就意味着能实现传动链的完全解耦。

X2 还将机器人的硬件系统抽象为一系列可复用的核心组件,包括小脑控制器 Xyber-Edge、域控制器 Xyber-DCU、智能电源管理系统 Xyber-8MS,以及经过“茫茫多”迭代的核心关键模组 Power Flow 等。

也就是说,通过这样模块化的组件设计,就可以像通过飞控,攒一台无人机航模一样,快速搭建起各种形态的人形机器人系统,这也是为什么X1原型机到X2研发这么快的原因之一。

在稚晖君看来,机器人并非一定是钢筋铁骨,因此他们尝试了大量的柔和材料,像TPU、ETPU、EVA 等多种材料,他们甚至考虑了用美妆蛋作为机器人的材料。

稚晖君表示,灵犀 X2 集三重角色于一身——不仅是一款支持高自由度、运动能力的双足人形机器人,还是一款搭载情感计算引擎的智能交互机器人,以及一款初步具备通用任务执行能力的具身机器人。

高自由度和任务执行能力都不难理解,其搭载的情感计算引擎,通俗的来讲就是更有“人味儿”了。

稚晖君表示,当前足式机器人的运动控制已经全面从传统的 Model based 转向 Learning 驱动的强化学习。

通过结合深度强化学习和模仿学习算法的优势,X2 可以不断的学习和进步,不仅学会了像人一样自然的走路,还能流畅地跑步和转弯,甚至还能跳科目三....

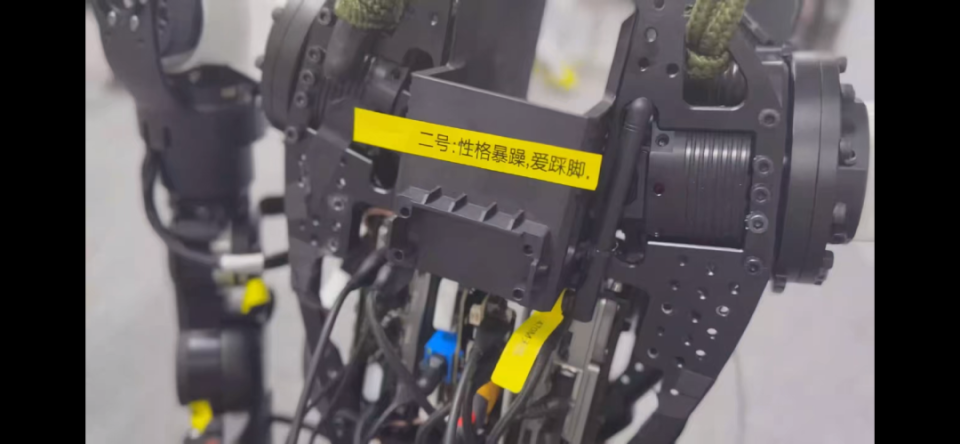

当然就像人一样,在学习的过程难免也会学到“抽象”一些的东西,X2也不例外。

比如在训练初期一不小心学“歪”了,有把跳跃当做平时移动方式的,还有一言不合就躺地上“摆烂”的,甚至还有被官方鉴定为“性格暴躁,爱跺脚”的另类机器人。。。

除了常规的行走,跑,跳外,为了偷懒,X2还能学会使用各种人类的懒人工具,比如踩滑板车,平衡车代步,甚至自己骑自行车。

为了让 X2 更有“人味儿”,智元团队增添了不少细节,比如灵犀X2能模仿人类呼吸韵律、具备人类好奇心和注意力机制、会一些“抖腿”小动作的肢体语言等。

目前,X2 仍在不断学习和进步。通过数据驱动的算法范式,智能机器人能够从每秒数万次与环境的互动和动作数据中,找到克服动作限制的方法,稚晖君表示,我们相信人形机器人的运动智能问题很快会得到彻底的解决。

能力进阶

作为一款人形机器人,光四肢发达还不行,头脑也不能简单,交互智能和作业生产必不可少。

在交互方面,借助当前最火热大语言模型技术,智元团队还为 X2 训练了定制的多模态交互大模型——硅光动语,从字面上,“光动语”分别代表着,视觉,动作,语音。

在这个大模型的加持下,灵犀X2也被稚晖君称为“第一台真正具备复杂交互能力的灵动机器人”。

在此基础上,通过边缘侧大脑和端到端模型架构,以及一系列工程优化,灵犀 X2 具备了毫秒级交互能力。

比如坐下聊天可以对答如流,面对“你是谁,你从哪来的,你存在的意义是什么”的人生三问,X2 都能顺畅回答。

当 X2 被问及它和狗同时掉水里,应该先救谁,会毫不犹豫地回答道先救狗,“因为它需要帮助,自己没事。”

最有意思的是,当稚晖君提问灵犀 X2“刚刚提的问有多少是预先写好的”,X2的语气还颇为得意,回答道“完全随机”。

基于 Diffusion 的生成式动作引擎,使得这款机器人不仅四肢协调,思维也颇为敏捷。

除了具备听觉和语言的交互能力,基于 VLM 的硅光动语多模态模型还能让 X2 通过视觉来理解和认识世界,识别眼前物体不在话下。

比如稚晖君拿出手机让 X2 自己看现在几点了,X2 能准确的回答出时间,还给睡不着的稚晖君推荐了牛奶,理由是有助于睡眠。

甚至还能真的“看到”物体上的小字,给稚晖君现场教学了一把。

情绪价值拉满的同时,稚晖君表示“我们的终极期待,是希望机器人能够成为构建社会生产力的重要分母”,也就是具备一定的生产能力。

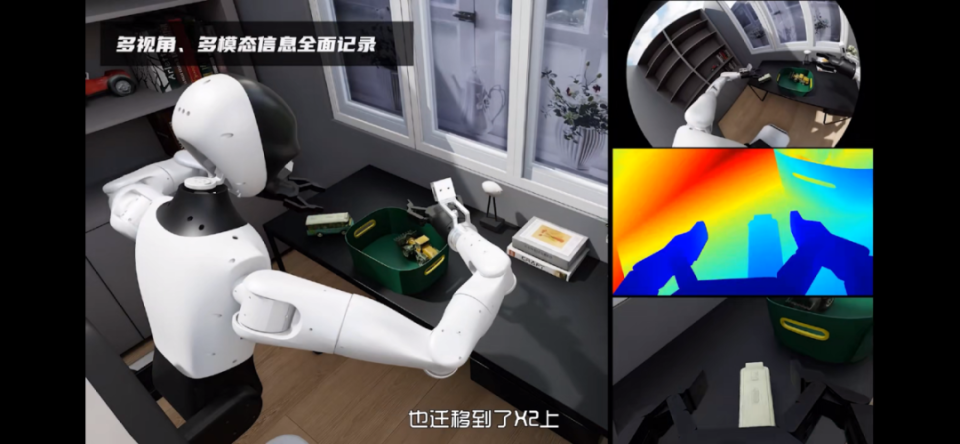

据稚晖君介绍,过去一年里,他们初步找到了一条通往泛化作业智能的路径,根据这些成果,他们也把操作智能的能力也迁移到了 X2 上。

在本体层面,X2 的本体支持很好的柔性阻抗控制,可以装配包括灵巧手在内的各种末端,使得其具备精细操作的能力,“针穿葡萄”的神技又重现江湖。

其次,在机器人的具身智能方面,团队也开源了业界最大之一的具身真机和仿真数据集。并提出了 RoboDual 的大小脑系统架构,以及刚刚发布的 ViLLA 架构具身基座大模型「启元」。

这也使得 X2 初步具备简单任务中对操作物体的零样本泛化能力,并在某些任务中实现多机协作,比如相互充电。

在视频的最后,稚晖君作为灵犀X2亲爹,像望子成龙一样,给了它一个最终的期望,就是希望作业能力可以外溢到日常生活的方方面面,实现机器人的“吉祥三保”---

就是保安、保姆和保洁。

神之一手

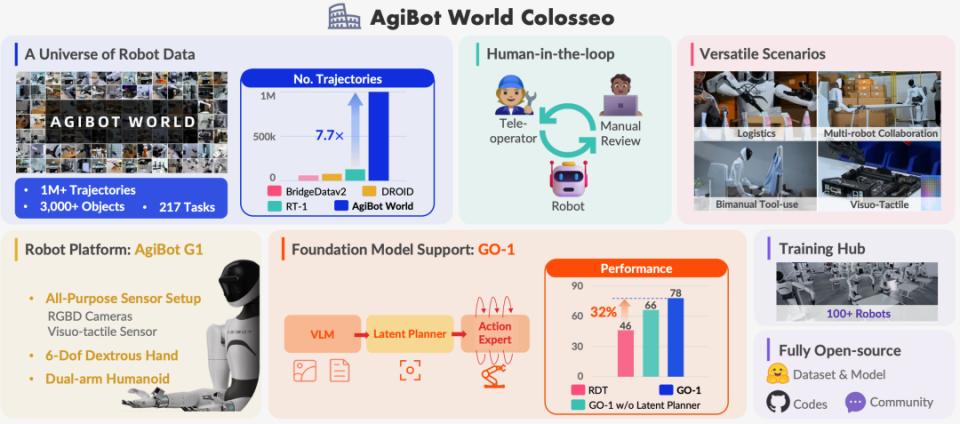

灵犀X2能够拥有“情感”、能够进行各类复杂任务,离不开智元机器人前一天发布的具身基座模型 GO-1。

GO-1 全称 Genie Operator-1,GO-1的发布,标志着机器人从“单一任务工具”正式迈向“通用智能体”。

在工厂,它能灵活切换装配、质检、物流等工种;在家庭,它可以从整理玩具进阶到辅导孩子作业;甚至在未来,机器人可能通过观看教学视频,自主学会维修电器。

GO-1 的一大黑科技就是开创性地提出了 ViLLA(Vision-Language-Latent-Action)架构,其整合了“两大模块”,三个“大脑”。

首先是多模态大模型(VLM),通过海量互联网图文数据训练,赋予机器人通用场景感知和语言理解能力,可以将其称之“视觉大脑”,靠刷遍全网图文,学会认杯子、桌子、咖啡机,甚至能听懂你喊“给我整杯82年的拉菲”。

另外还有专家混合模块(MoE),这其中又包含两个关键组件:

首先是规划层面上,隐式规划器(Latent Planner)生成任务链,优化任务执行流程,利用跨本体和人类操作视频数据,学习通用的动作理解能力,可以将其称之为“动作大脑”。

比如,可以将复杂任务分解为一系列可执行的子任务。以 “挂衣服” 为例,机器人需分解为抓取衣架、调整角度等步骤,并根据实际情况灵活调整执行顺序和参数,确保任务的高效完成。

另外,就是“抠细节小能手”(Action Expert),在执行层面上,基于百万级真机数据生成精细动作序列,使灵犀 X2 的动作更加流畅、精准。例如,在倒水任务中,误差可控制在 ±3ml 内,满足日常生活和工业生产的高精度操作需求。

这几个部分协同工作,使模型能够通过人类视频进行小样本学习,并快速泛化到新任务和新环境中,实操证明,这套架构下的能力确实不错。

在五项复杂度不同的任务测试中,GO-1 的平均成功率较现有最优模型从46%提升到了78%,尤其在倒水、清理桌面和补充饮料等任务场景中表现突出。

更为关键的是它的进化速度,GO-1支持跨本体数据共享,这意味着每台机器人的经验都能反哺系统。假设一个机器人学会拧螺丝,那么其他机器人立刻能同步技能。

智元机器人也计划年内推出基于强化学习的Foundation Model,进一步释放机器人的自主决策潜力。

按照他们的设想,五年内要让机器人走进客厅,或许用不了多久当你推开家门,迎接你的将是一个正在忙碌的机器人了。